شركة صينية محرومة نشرت نموذج ذكاء صناعي اسمه DeepSeek تزلزل الكيان الأمريكي زلزلةً لم يعرفها قط، وترغم أنفه في التراب صاغرًا، خسفت بالسوق الأمريكي خسفًا شديدًا لم يُرَ مثله، في يومٍ واحدٍ خَسِرَ الألوف المؤلفة من الدولارات، هبطت أسهم شركة نفيديا Nivida فيه بنسبة ١٧٪، وهو أول هبوط في يوم شهدته شركة أمريكية على مر التاريخ!

أحدثك اليوم عنه وأعرفك بالضجة التي حدثت ثم أثبته لك على حاسوبك إن شاء الله، لكني قبل ذلك لا بد لي من تعريفك بالنماذج اللغوية الكبيرة Large Language Model، اختصارًا LLM.

ما النموذج اللغوي الكبير LLMs

النموذج اللغوي الكبير: نموذج يُنتج النصوص، أي يكتب بلسان القوم، بتمرنه على ركام من الكلام كالجبال، وعند تمرنه عليه يقدر على إنتاج كلام مثله، لكن لا يفهمه، لا يفهم النصوص المولدة، فهو لا يفهم دلالات الألفاظ Semantics، بل يتنبأ بالكلمات وفق احتمالات محسوبة، فمرد هذه النماذج كلها إلى إحصاء واحتمالات محسوبة، وما دام هذا حالها فإنها لن تستولي على العالم كما في مرئيات Films الخيال العلمي.

أشتهرت هذه النماذج قبل مدة وصارت حديث الناس وديدنهم، أمثال هذه النماذج كان ChatGPT، فهو نموذج لغوي كبير تمرن على ركام من الكلام عظيم، والنموذج Claude-3.5-Sonnet-1022 وغيرهما. تحتاج هذه النماذج إلى موارد حاسوب ضخمة حتى تشتغل، مثل وحدات المعالجة الرسومية GPUs القوية التي تنتجها شركة الأمريكية Nivida لقوتها وتطور صناعتها، ومثل الطاقة لأن وقت التمرن يستمر لأيام وأسابيع وأشهر طوال، فلا بد من طاقة طيلة وقت التمرن. وكما قرأت، لا بد من وحدات معالجة رسومية قوية التي تنتجها شركة Nivida، لكن الشركات الصينية محرومة منها، فقد فرضت أمريكة عليها العقوبات وقيدتها ومنعت عنها كل ذلك.

نموذج DeepSeek

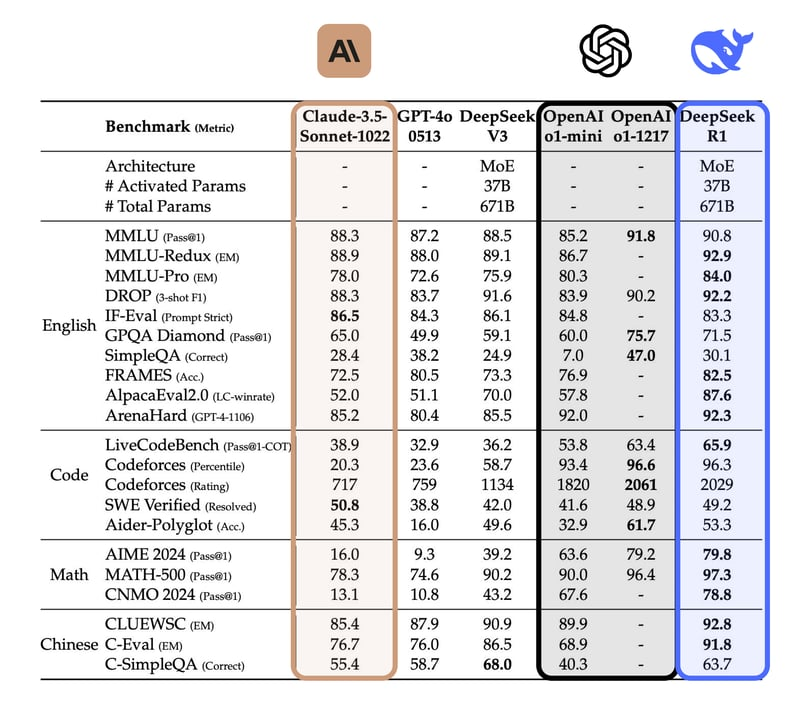

نشرت شركة صينية اسمها DeepSeek نموذجها الذي أسمته DeepSeek-R1 بالمجان وتركته مفتوح المصدر Open Source، والذي بلغ في الجودة مرتبة مقاربة أو مساوية نموذج ChatGPT المدفوع، وفعلت الشركة هذا كله بثمن بخسٍ وبموارد هينة، فلم تصرف ما صرفته شركة OpenAI على نموذجها ChatGPT، ولم تستعمل تقانة متطورة مثل وحدات المعالجة الرسومية من Nivida، بل قالت إنها استطاعت تمرين نموذجها بوحدات معالجة أضعف وبثمن بخسٍ، فلم يكلفها مالًا كثيرًا.

أي أنها تفوقت على الأمريكي المهيمن الذي يمتلك الأموال وأحدث التقنيات وجعلت نموذجها مفتوح المصدر، يصل له الجميع ويستعلمه، وكل هذا بتكلفة وموارد أقل من المهيمن الأمريكي. وكما قرأت في الفقرة الآنفة وحدات المعالجة الرسومية محرومة منها الصين، ومثلها دول عربية، لكنها استطاعت تمرين نموذجها بموارد أقل بأضعاف كثيرة، وإنه لإنجاز لم تسبق فيه، وبما أنها استطاعت فعل ذلك بموارد حاسوبية أقل فإن الطلب على الصناعة الأمريكية لوحدات المعالجة الرسومية المستعملة في الذكاء الصناعي سيقل، وهذا سبب الخسارة في السوق الأمريكي!

اشتهر كالنار في الهشيم، وتصدر البرنامج متاجر البرامج الأمريكية مثل متجر برامج Apple، ولشدة الخبث الأمريكي تعرضت الشركة الصينية لهجوم شل خواديمها servers فأُجبِرت على إغلاق التسجيل وتخلل البطء خدمتها، وذاعت الإشاعات التي تضر بسمعتها وتقدح في نموذجها وتتهمها بأشنع الاتهامات!

وما هذا إلا الخبث الذي يسري في الثقافة الأروبية المسيحية الفاجرة، وصار متجلِّيًا لا خفاء فيه من الذي يعيق تقدم الأمم ويحاربها بشتى الوسائل وأبشعها، فلا غلبة إلا لها، وها قد أرغم الوحش الصيني أنفها في التراب صاغرة وقد هتك كبرياءها وهدَّها هدًّا.

لأن الشركة تعرضت لهجوم شل حركتها فلم يقدر كثير من الخلق على استعمال النموذج فإني معرفكم اليوم بطريقة تثبيته على حاسوبكم!

سنثبت نماذج مصغرة من النموذج لكنها تبقى قوية وتؤدي الغرض وستعمل على حاسوبك، وسنتستعمل برمجية Ollama لتشغيلها.

برمجية Ollama

برمجية لتشغيل وإدارة النماذج اللغوية الكبيرة على حاسوبك، إذ تسهل التنزيل لها والتشغيل دون الحاجة لموراد حاسوبية قوية. البرمجية تعمل على لينكس وماك وويندوز، ومما تقدمه البرمجية: الواجهات البرمجية للبرامج application programming interface، اختصارًا API، فتقدر على تضمينها في برمجياتك أيها المبرمج!

تثبيتها

لنشرع في تثبيتها على الأنظمة الثلاثة ونستفتحها بلينكس ولذلك بأمر واحد لا غير!

افتح المطراف Terminal واكتب:

curl -fsSL https://ollama.com/install.sh | shثم شغلها بأمر:

ollama serveولتتحقق من عملها افتح مطرافًا آخر واكتب:

ollama -vعلى ويندوز:

افتح موقعها هاهنا ونزل المثبت الذي اسمه OllamaSetup.exe.

٢. شغل المثبت وسيبدأ التثبيت

٣. لما ينتهي التثبيت ستعمل البرمجية في الخلفية. افتح سطر أوامر مثل PowerShell واكتب الأمر التالي لتتحقق من تثبيتها هل تمّ أم لا:

ollama -vعلى ماك:

افتح موقعها هاهنا ونزل المثبت

٢. شغل المثبت وسيبدأ التثبيت

٣. لما ينتهي التثبيت ستعمل البرمجية في الخلفية. افتح سطر الأوامر واكتب الأمر التالي لتتحقق من تثبيتها هل تمّ أم لا:

ollama -vنماذج الوحش الصيني على Ollama

النماذج في مكتبة البرمجية (Ollama) أنواع وأحجام، فكلما زاد حجمها زادت الموارد اللازمة لتشغيلها، والأحجام تكون هكذا: 1.5b, 7b, 8b، وحرف b اختصار كلمة billion، أي ألف مالِ ألف (مليار) معلمة parameters، لكن ما معناها؟

اعلم أنها كلما زادت زادت قوة النموذج ودقته، وتفصيلها في مقالات قادمة عن الذكاء الصناعي إن شاء الله.

أما أنواع النموذج فهي:

النسخة الكمية Quantized models: والتكميم التقليل من دقة النموذج من أجل تقليل استهلاك الذاكرة وتسريع النموذج، وهذه النماذج تفقد الدقة أو الجودة التي تتحلى بها النماذج الأصلية. النماذج مثل q4_K_M أو q8_0 نماذج كمية، والأرقام p8 وq9 تشير إلى مقدار الجودة المفقودة.

النسخة المخففة أو المقطرة Distilled Versions: وهذه نماذج أصغر تمرن للعمل كالنماذج الكبيرة مع موازنة الأداء واستهلاك الموارد، هذه النماذج مثل qwen-distill وllama-distill.

وهذه لائحة بكلها:

1.5b7b8b14b32b70b671b1.5b-qwen-distill-fp161.5b-qwen-distill-q4_K_M1.5b-qwen-distill-q8_014b-qwen-distill-fp1614b-qwen-distill-q4_K_M14b-qwen-distill-q8_032b-qwen-distill-fp1632b-qwen-distill-q4_K_M32b-qwen-distill-q8_070b-llama-distill-fp1670b-llama-distill-q4_K_M70b-llama-distill-q8_07b-qwen-distill-fp167b-qwen-distill-q4_K_M7b-qwen-distill-q8_08b-llama-distill-fp168b-llama-distill-q4_K_M8b-llama-distill-q8_0

كيف تختار واحدًا؟

ما دمت عرفت النماذج الكمية والمخففة وعرفت الأحجام فجرب واستكشف ما يعجك وابدأ بالصغير!

ووجب التنبيه أن لكل واحدة منها وسمًا اسمه latest ويعني أحدث نسخة. لنثبت واحدًا!

تثبيت النموذج

صيغة أمر تثبيت النموذج:

ollama run deepseek-r1:<model_tag>نستبدل كلمة <model_tag> بالنموذج المُراد، مثلًا سنثبت النموذج 7b، سيكون الأمر:

ollama run deepseek-r1:7bالأمر ينزل النموذج إن لم يُنزَّل ويشغله، وعندما يشتغل سيفتح محادثة ووقتئذٍ اسأله ما تحب!

لتثبيت نموذج عُمِلَ له التكميم والتخفيف وحجمه 14B نكتب:

ollama run deepseek-r1:14b-qwen-distill-q4_K_Mولو أردت آخر نسخة فأضف كلمة latest في النهاية:

llama run deepseek-r1:14b-qwen-distill-q4_K_M-latestوهكذا باقي النماذج!

أوامر Ollama

هذه بعض الأوامر التي يجدر بك معرفتها:

ollama -vيعرض إصدار البرمجية

ollama pull <model_name>:<tag>ينزل النموذج من مكتبة البرمجية دون تشغيله

ollama run <model_name>:<tag>يشغل النموذج وينزله إن لم يُنزَّل

ollama show <model_name>يعرض معلومات عن النموذج

ollama psيعرض النماذج التي تعمل الآن

ollama stop <model_name>يوقف النموذج الشغال

ollama delete <model_name>يحذف النموذج

لا تنس أن تسبدل ما بين <> بالنموذج…

الخاتمة

ها قد وصلنا إلى نهاية المقال، وها أنا أخط بقلمي الخطوط الأخيرة لهذا المقال الشائق، وأرجو إني قد وفِّقت في الشرح.

وفي نهاية الأمر لا يسعني سوى أن أشكرك على حسن قراءتك لهذا المقال، وأني لبشر أصيب وأخطِئ، فإن وفِّقت في طرح الموضوع فمن اللّٰه عز وجل وإن أخفقت فمن نفسي والشيطان.

أرجو منك تقييم كفاءة المعلومات من أجل تزويدي بالملاحظات والنقد البناء في خانة التعليقات أو عبر حساب الموقع، والسلام عليكم ورحمة اللّٰه تعالى وبركاته.